Više od 100 znanstvenika Sveučilišta Stanford upozoravaju na to da prijedlog europskog zakona o umjetnoj inteligenciji ne uzima u potpunosti u obzir nedavni uspon nove vrste umjetne inteligencije, što znači da će zakonodavstvo vrlo brzo zastarjeti dok se tehnologija primjenjuje na nove i neočekivane načine.

Konkretno, akademici su zabrinuti da bi temeljni modeli mogli zaraziti sve sustave umjetne inteligencije nepristranošću i sigurnosnim rizicima, a trenutačni prijedlog Europske komisije o reguliranju AI-ja neće biti u stanju ublažiti prijetnju koju takvi modeli predstavljaju.

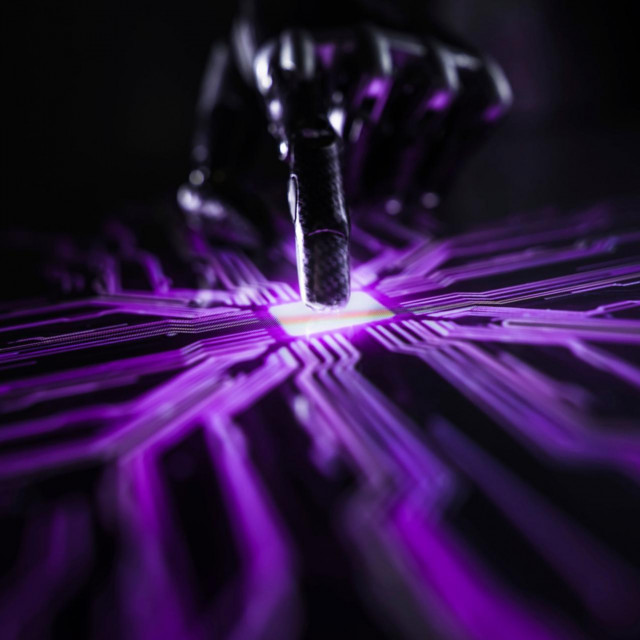

Temeljni modeli su algoritmi strojnog učenja koji su obučeni na različitim tipovima podataka i mogu se primijeniti na širok spektar aplikacija. Vjerojatno najpoznatiji takav model je GPT-3, model predv...

Za sudjelovanje u komentarima je potrebna prijava, odnosno registracija ako još nemaš korisnički profil....